1.Introdução

A democratização do acesso à informação tem sido um dos principais motivos que permitiu a melhoria da qualidade de vida da sociedade. Durante o século XX, assistimos o surgimento e o crescimento da Internet com uma velocidade incrível. No ínicio da era comercial da grande rede de computadores, apenas pessoas que possuíam linha telefônica tinham acesso a rede mundial de computadores. Em seguida surgiram tecnologias como DSL, ADSL, ligações através de TV à Cabo e por rádio. O número de pessoas conectadas a rede cresceu de forma assustadora. No final da década de 90 surgiu uma tecnologia capaz de atingir ainda mais residências. Conhecida como PLC - Power Line Comunications - ou BPL - Broadband over Power Lines, permite o acesso a rede mundial de computadores através da utilização da rede elétrica já existente em mais de 95% do território brasileiro. Neste artigo, abordaremos um pouco do histórico dessa conexão, bem como sua arquitetura de funcionamento. Também discutiremos sobre suas vantagens e desvantagens comparadas a outros modos de conexão.

2.Histórico:

Por volta de 1920 já era perceptível a iniciativa da utilização da fiação eléctrica para a transmissão de dados, com tecnologias remotas mas bastantes usuais como a transmissão de pulsos de telégrafos sobre redes trifásica. na época tornava-se inviável aprofundamento de tais pesquisas, mas com os avanços da microeletrônica e o barateamento de equipamentos voltou a ser um assunto interessante a se pensar, passando a se chamar PLC-Power Line Comunications. Uma das primeiras tentativas foi com o "Riple Control" onde seria utilizada no controle da iluminação pública. Com as atuais pesquisas pode-se chegar a uma taxa de transmissão por volta 45Mbps com utilização de 72 portadoras de alta freqüência simultaneamente.

2.1.PLC Brasil:

A CEMIG. veio com o primeiro investidor nessa tecnologia no Brasil onde visava utilizar a tecnologia x10 para a transmissão em horários de pico, para que fosse distribuída homogeneamente. A companhia também utilizava a tecnologia para leituras automáticas nos medidores de consumo onde um simples laptop poderia se conectar a um transformador onde nele onde nele conterias as leituras mensais do bairro inteiro.

Outras companhias como a COPEL (PR), CELG (GO), Light (RJ), ELETROPAULO (SP) e EXCELSA fazem implementação de acesso à Internet via rede elétrica em residências para testes, mas pretendem disponibilizar ao público.

3. Funcionamento básico:

O princípio do funcionamento da BPL é que como a freqüência do sinal de conexão é na faixa dos MHz (91,7 a 30) e a energia elétrica é da ordem dos Hz (50 a 60 Hz) os dois sinais podem conviver tranqüilamente no mesmo meio. O sinal BPL é enviado pela central para um equipamento chamado INJETOR BPL, que se encarrega de inserir o sinal da Internet da rede elétrica. O sinal chega a outro equipamento chamado REPETIDOR BPL cuja função é não deixar que o sinal de Internet não seja atenuado. Quando o sinal chegar ao EXTRATOR BPL é convertido para ser usado pelo computador do usuário final. Vale informar que a velocidade do PLC possui velocidade não assíncrona. Isso significa dizer que se tem o mesmo desempenho tanto no envio, quanto no recebimento de dados. Analisemos o esquema a seguir:

QUADRO 1 - Esquema de sinalização via rede elétrica.

FIGURA 1 - Esquema de sinalização via rede elétrica.

3.1.Vantagens:

As vantagens da conexão BPL são: sua infra-estrutura atinge praticamente 95% dos lares brasileiros, o que significa uma redução na implantação sem comparações com outras tecnologias. Outro ponto positivo é a alta taxa de transmissão que pode alcançar 40Mbps atuando na freqüência de 1,7MHz a 30MHz. Uma característica importante da conexão na rede elétrica é o conceito de grids inteligentes:eles têm a função de monitorar a extensão da fiação elétrica, permitindo reduzir as perdas na transmissão. Por exemplo, no caso da queima de um transformador, é possível saber exatamente em que ponto o problema ocorreu.

3.2.Desvantagens:

Embora seja uma tecnologia promissora, a BPL também possui suas desvantagens:

· O sinal acaba atenuando (enfraquecendo) após percorrer distâncias muito longas.

· A freqüência utilizada pelo sinal pode interferir em alguns equipamentos eletro-eletrônicos; de forma idêntica, outros aparelhos podem interferir na transmissão

· A necessidade de instalação de repetidores em cada transformador externo, pois filtram sinais de alta freqüência

· A Impedância variável - Como a fiação das residências foram feitas para que o aparelhos e dispositivos funcionam em paralelo o ligamentos e desligamentos de tais equipamentos mudariam completamente a situação da rede de forma freqüente atenuando assim o sinal de transmissão.

· A Indutância elevada dos fios - os fios são livres de qualquer blindagem e também espesso e longos a indutâncias resultante em altas freqüências causam grandes atenuações nos sinais.

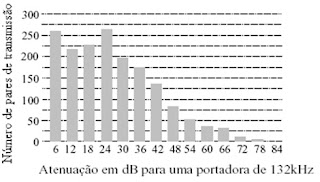

GRÁFICO 1 - Histograma de atenuação

4.Legislação:

Com o surgimento de qualquer nova tecnologia, faz-se necessário uma regulamentação. Na área de transmissão de dados via rede elétrica pode ocorrer a interferência em outros meios de transmissão como radio e televisão. Além de existir o fato da radiação eletromagnética. Abordaremos a regulamentação que torna essa tecnologia segura e que não interfira em outros meios de comunição.

4.1.Padronização:

Existem duas formas de padronização internacional tais como a americanada FCC (Federal Communications Comissiona), que permite qualquer comunicação desde que a portadora esteja abaixo de 525Khz e existe a Européia CENELEC (Comité Européen de Normalisation Electrotechnique que divide as faixas de acordo com o tipo de aplicação.

Banda A - de 9 a 95kHz - Para empresas de fornecimento de energia;

Banda B - 95 a 125kHz - Para uso público sem protocolos;

Banda C - 125 a 140kHz - Para uso público com protocolos;

Banda D - 140 a 148,5kHz - Para uso público sem protocolos;

Acima de 148,5kHz as comunicações via rede elétrica são proibidas.

No Brasil com surgimentos das empresas estrangeiras no mercado, ocorreu um encontro para a regulamentação com a ANATEL (Agência Nacional de Telecomunicações) e com o apoio do CBC-7(Comissão Brasileira de Telecomunicações 7), em 13 de Abril de 2009 foi aprovado por unanimidade as normas tecnicasparao uso da PLC .Veja materia da epoca. http://convergenciadigital.uol.com.br/cgi/cgilua.exe/sys/start.htm?infoid=18438&sid=8

Conclusão

Observa-se que há um grande empenho da comunidade em desenvolver tecnologias de baixo custo visando um maior acesso da população à Internet, A PLC vem sendo uma das tecnologias mais promissoras nessa área, com os testes que vem sendo realizados nota-se que ainda tem muito a desenvolver, porém observa-se que a velocidade em que tais evoluções ocorrem, nos faz entender, que em um curto espaço de tempo, uma significativa parcela da população terá acesso a banda larga de qualidade e a baixo custo. Tal evolução não está relacionada somente a área de comunicação, mas abrange todos os campos sociais como educação, saúde e segurança alvos maiores dos governos e da população em geral.

Autores:

César Augusto Freitas Azevedo

Cláudio Henrique Bezerra de Souza

Credson Isaac L. dos Santos

Camila Munay Dantas Frutuoso

Laudo Ferreira Júnior

5. REFERÊNCIAS

MONQUEIRO Júlio César Bessa. Entendendo a Internet sob rede elétrica. Disponível em <http://www.guiadohardware.net/artigos/internet-rede-eletrica>Acesso em: 05 julho 2009.

PLC - Power Line Communication - Banda larga pela rede elétrica. Fórum de discussão. Disponível em <http://www.wirelessbrasil.org/wirelessbr/secoes/plc_banda_larga_rede_eletrica/resumo.html>Acesso em: 05 julho 2009.

MARQUES, Gabriel Alan Gehm. Transmissão de dados via rede elétrica. Monografia submetida à Universidade Federal de Santa Catarina. Disponível em:.<http://www.wirelessbrasil.org/wirelessbr/colaboradores/gabriel_marques/dados_via_rede_01.html >. Acesso em: 05 julho de 2009.